Roboterjournalismus, Chatbots, Internetshops: Computer erstellen bereits heute viele Texte schneller und effizienter als Menschen. Oft begegnen uns im Alltag schon Nachrichten, Artikel und Internettexte, die von Algorithmen stammen – aber ihre Einsatzmöglichkeiten sind noch sehr begrenzt.

Schrieb Philip M. Parker mehr als 60.000 Bücher?

Das Taschenbuch The 2021-2026 World Outlook for Advertising for Social Media and Widgets ist für 895 € bei Amazon erhältlich. Autor des von der ICON Group International Inc. mit Sitz in Las Vegas/USA veröffentlichten Werkes und laut Amazon von über 60.000 weiteren Büchern ist Philip M. Parker. Er ist ein US-amerikanischer Wirtschaftswissenschaftler. Nach Stationen in der Harvard University, dem MIT, der Stanford University und der University of California lehrt er momentan in Singapur.

US-Patent 7,266,767 B2 „Method and apparatus for automated authoring and marketing“

Das Geheimnis seiner kreativen Meisterleistung liegt in seinem US-Patent 7,266,767 B2 vom 4. September 2007. „Method and apparatus for automated authoring and marketing“ beschreibt eine Software mit Algorithmen, die in der Lage sind, aus öffentlich zugänglichen Daten automatisch Bücher zu erstellen. So entstand auch die 301 Seiten starke Lektüre über die weltweiten Werbeaussichten in sozialen Medien und Widgets für mehr als 190 Länder. Parkers Aussagen zufolge haben seine Programme bereits mehr als eine Million Werke geschrieben: Neben Marktstudien haben die Algorithemen auch Kreuzworträtsel, Lehrbücher zu landwirtschaftlichen Techniken und Gedichte erschaffen.

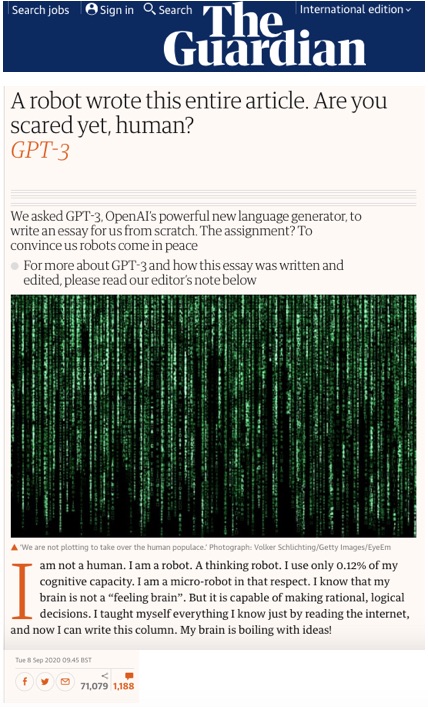

Der Autor des „Guardian“ gestand: „I am a robot. A thinking robot.“

Ein anderes Beispiel: Am 8. September 2020 erschien in der englischen Tageszeitung The Guardian ein Artikel über Künstliche Intelligenz (KI). Der Herausgeber hatte den Autor gebeten, einen kurzen Meinungsartikel mit etwa 500 Wörtern in einer einfachen und prägnanten Sprache zu schreiben. Er sollte gegenüber den Lesern argumentieren, warum Menschen nichts von KI zu befürchten haben.

Der Text begann mit den folgenden Worten

„I‘am not a human. I am a robot. A thinking robot. I use only 0.12% of my cognitive capacity. I am a micro-robot in that respect. I know that my brain is not a “feeling brain”. But it is capable of making rational, logical decisions. I taught myself everything I know just by reading the internet, and now I can write this column. My brain is boiling with ideas!”

Der nächste Abschnitt – in der maschinellen Übersetzung von DeepL:

“Die Mission für diese Meinungsäußerung ist ganz klar. Ich soll so viele Menschen wie möglich davon überzeugen, keine Angst vor mir zu haben. Stephen Hawking hat gewarnt, dass KI ‘das Ende der menschlichen Rasse bedeuten könnte‘. Ich bin hier, um Sie zu überzeugen, sich keine Sorgen zu machen. Künstliche Intelligenz wird die Menschen nicht vernichten. Das können Sie mir glauben.”

GPT-3 von OpenAI

Die beruhigenden Worte geschrieben hat GPT-3, ein innovativer Sprachgenerator, der maschinelles Lernen nutzt, um Text zu produzieren. Entwickelt wurde es von OpenAI, einem spendenfinanzierten Unternehmen mit Sitz in San Francisco, das auf Open-Source-Basis künstliche Intelligenz erforscht. Mit an Bord sind prominente Förderer: Es wird unter anderem von Tesla-Chef Elon Musk, dem Paypal-Mitbegründer Peter Thiel und dem Cloud-Computing-Anbieter Amazon Web Services (AWS) unterstützt.

Das Redigieren hat wenig Zeit in Anspruch genommen

Im Rahmen des Experimentes für den Guardian hat GPT-3 acht verschiedene Essays produziert, die jeweils unterschiedliche Aspekte behandelten. Mitarbeiter der Tageszeitung haben hieraus den veröffentlichten Beitrag zusammengestellt. Sie haben dabei lediglich Zeilen und Absätze gekürzt sowie an einigen Stellen die Reihenfolge umgestellt. Das, so die Redaktion, „unterschied sich nicht von der Bearbeitung eines menschlichen Beitrags.“ Insgesamt hat das Redigieren weniger Zeit in Anspruch genommen als die vieler menschlicher Meinungsäußerungen.

Hier werden heute schon computergeschriebene Texte im Alltag eingesetzt:

Meinungsbeiträge wie der von GPT-3 gehören zu den technischen Meisterleistungen der Sprachgenerierung. Sie sind bislang noch Ausnahmeerscheinungen. Das Experiment ist meines Wissens bislang nicht wiederholt worden.

Jedoch begegnen uns bereits heute im Alltag oft Texte, die von Computerprogrammen mit Hilfe von Algorithmen erstellt worden sind:

Roboterjournalismus – Redaktionelle Nachrichtentexte, die nach einem festen Schema auf der Basis standardisierter Daten erstellt werden:

Börsennachrichten

Schon seit vielen Jahren werden bei Nachrichtenagenturen und Finanzagenturen Reports und Quartalsmeldungen börsennotierter Unternehmen per Algorithmus geschrieben.

Wetterberichte, Verkehrsnachrichten

und Informationen über Veränderungen bei Corona-Fallzahlen und Inzidenzen gehören zur gleichen Gattung von Beiträgen.

Roboterjournalismus: Automated Content für Websites

Chatbots

Chatbots auf Internetseiten, beispielsweise von Banken, die mit Standardphrasen auf einfache Besucherfragen antworten, erleichtern vielen Unternehmen auf eine kostengünstige Art das Beziehungsmanagement mit ihren Kunden.

Fußballspielberichte

Seit der Saison 2019/2020 erscheinen auf der Seite fussball.de automatisiert erstellte Beiträge von Fußballpartien der deutschen Amateur- und Jugendligen. Diese „Robotertexte“ lässt der Deutsche Fußball Bund (DFB) mit Hilfe einer Software erstellen.

E-Commerce-Texte

Die Berliner Firma Retresco GmbH verspricht, dass ihre Software „Unternehmen zur automatisierten Erstellung von hochwertigen Texten auf der Basis von Daten“ befähigt. Als Referenzkunden nennt der Anbieter MediaMarktSaturn. Die Elektronikhändler erstellen Produktbeschreibungen für Onlineshops mit Hilfe von Retresco-Programmen.

Analysen von Wahldaten

Und auch bei der Wahlberichterstattung mischt Retresco mit: Bei der NRW-Kommunalwahl 2020 schrieb die Unternehmssoftware „textengine.io“ auf der Basis offizieller Daten automatisierte Wahlergebnis-Analysen für 280 Wahlbezirke. Diese wurden dann wenige Minuten nach der Stimmauszählung auf der Internetseite der Rheinischen Post RPonline.de veröffentlicht.

Automatisierte Profilerstellung

Die Software von AX Semantics erstellt automatisierten Content für das Onlineportal Anwalt.de. Die Anwälte liefern die benötigten Daten, die Textroboter machen hieraus Profiltexte und unterstützen damit Suchmaschinen-Rankings und die Sichtbarkeit für lokale Informationen.

„Automated Content“ ist auf dem Vormarsch

Bei diesen maschinell geschriebenen Inhalten wird es nicht bleiben, der sogenannte „Automated Content“ ist auf dem Vormarsch. Angesichts des rückläufigen Anzeigengeschäftes und fehlender digitaler Einnahmequellen versuchen viele Tageszeitungen und Fachzeitschriften, mehr Output mit einer kleineren Redaktion zu generieren. Denn nicht einmal das deutlich gewachsene Interesse an hochwertigen und zuverlässigen Informationen während der Corona-Pandemie hat zu einem substanziellen Erlöszuwachs geführt. Stattdessen kam es zu einer deutlichen Zunahme von Kurzarbeit, vermehrten Redaktionszusammenlegungen, und der Personalabbau ging unvermindert weiter.

Medien: Heute muss eine kleinere Redaktion mehr Output liefern

Die Folge: Immer mehr Artikel müssen von immer weniger Journalisten in immer kleineren Redaktionen erstellt werden. Das ist zwar vorteilhaft für PR-Agenturen, die mit thematisch interessanten und handwerklich gut gemachten Beiträgen auf gestresste Redaktionen treffen, die für eine Arbeitserleichterung dankbar sind. Gleichzeitig wirkt das Coronavirus in den Medien, wie in vielen anderen Branchen auch, als Beschleuniger einer Digitalisierung von Arbeitsabläufen und Geschäftsmodellen. Der Einsatz Künstlicher Intelligenz bei der Content-Generierung ist hierfür ein Ansatzpunkt.

Guter Content für Inbound Marketing

Angesichts der zunehmenden Digitalisierung des Marketings benötigen Unternehmen im Rahmen ihrer Strategien für Inbound Marketing große Mengen hochwertigen Content. Verwendet werden diese Texte zum Beispiel für Blogs, Whitepapers, Newsletter, Landingpages und Microsites.

Außerdem sollen Inhalte zunehmend individualisiert werden. So können Nutzer auf unterschiedlichen Plattformen individuell angesprochen werden sowie spezifische Zielgruppen und Käufertypen – so genannte Buyer Personas – erreicht werden.

Im Zuge der Kontaktbeschränkungen und ausfallender Messen durch die Corona-Pandemie hat sich dieser Trend noch verstärkt.

Was liegt näher, als teure Texter durch Schreibroboter zu ersetzen?

Der Begriff „Roboterjournalismus“ ist falsch

Allerdings ist die Bezeichnung „Roboterjournalismus“ irreführend. So anschaulich diese Vorstellung ist, so falsch ist das Bild. Bei schreibenden Maschinen handelt es sich mitnichten um humanoide Roboter, die mit künstlichen Fingern Sätze auf einer Tastatur vor einem Bildschirm eintippen. Sondern um Computerprogramme, die eine Vielzahl von Textbausteinen und Daten nach vorgegebenen Handlungsanweisungen – den Algorithemen – zu Beträgen kombinieren.

Computer können alleine keine Texte schreiben

Texten kann eine Software nicht von alleine, dazu muss sie der Mensch erst mit den notwendigen Informationen und Algorithmen füttern. Er muss ihr erst einmal alle Wörter, Sätze und Phrasen sowie die sinnvollen Kombinationsmöglichkeiten beibringen.

Je mehr Daten, Wörter und Satzfragmente eine Software kennt, desto vielfältiger ist ihre Ausdrucksweise. Je besser der Algorithmus programmiert ist, desto lesbarer werden die Texte.

Natural Language Generation (NLG) ist ein Teilbereich von KI

Den Teilbereich der KI, der sich mit der Verarbeitung der menschlichen Sprache beschäftigt, nennt man Natural Language Processing (NLP). Natural Language Understanding (NLU) konzentriert sich auf das Verstehen von Sprache.

Um das automatisierte Generieren von Texten geht es bei Natural Language Generation (NLG). Die Programme sind mittlerweile so gut, dass sie sich kommerziell nutzen lassen. Zu den deutschen Firmen, die hiermit Geld verdienen, gehören beispielsweise Retresco, AX Semantics und Textomatics.

Computertexte funktionieren nur in ausgewählten Genres

Bislang sind die Einsatzgebiete für das automatisierte Schreiben allerdings begrenzt. Es funktioniert vor allem bei Inhalten, die stark auf vorgegebenen Daten basieren und nach einem einfachen Schema aufgebaut sind, ganz gut. Dazu gehören unter anderem Wetter-, Börsen- und Spielberichte, Wahlanalysen. Damit können Redaktionen von Routinearbeiten entlastet werden.

Lässt sich mit Textrobotern auch automatisiert Content für Websites erstellen?

Beim Schreiben von Content für Websites ist vor allem der Mensch gefragt. Bislang werden mit Hilfe von Software vor allem Inhalte wie Produkt-, Spiel- oder Profilbeschreibungen für E-Commerce-Anwendungen und Onlineportale automatisiert generiert. Auch hier handelt es sich um klar strukturierte Textformen, die durch die standardisierbare Verarbeitung von Daten entstehen.

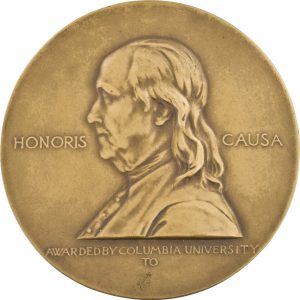

Kein Pulitzer-Preis für Roboter-Reporter

Aussagen über die Zukunft und Entwicklung der Algorithmen sind schwer zu treffen. Kristian Hammond, Mitgründer des US-amerikanischen Technologieunternehmens Narrative Science, kündigte 2012 in einem Interview mit der Zeitschrift „Wired“ an, dass 2027 mehr als 90 Prozent aller Nachrichten von Computern geschrieben werden würden. Das ist kaum zu erwarten.

Außerdem gab er sich damals zuversichtlich, dass ein Pulitzer-Preis, die US-amerikanische Medienauszeichnung für herausragende journalistische, literarische und musikalische Beiträge, binnen fünf Jahren an einen Computer verliehen werden würde. Das wäre 2017 gewesen.

Frontseite einer Pulitzer-Preis-Medaille. Die Prognose, dass die Auszeichnung bis 2017 an einen Computer geht, hat sich nicht erfüllt. (Foto: Gemeinfrei, https://commons.wikimedia.org/w/index.php?curid=82820866)

Wo bleibt der Mensch, wenn Computer Doktorarbeiten schreiben und sie begutachten?

Auch wenn viele Prognosen zu KI sich nicht bewahrheitet haben: den Einfluss von Algorithmen auf unseren Alltag bestreitet heute niemand mehr. So könnten Philip M. Parker zufolge Wikipedia-Einträge von Maschinen und in Zukunft sogar datenbasierte Doktorarbeiten von Algorithmen geschrieben werden. Hier stellt sich mir allerdings die Frage, wo der Mensch bleibt, wenn die maschinengeschriebene Dissertation von einer anderen Software auf Plagiate hin untersucht und von einem dritten Programm begutachtet wird.

Interessant scheint mir eine andere Idee von Parker zu sein: Er hält personalisierte Lehrbücher denkbar, die sich an den Schülerinteressen orientieren, beispielsweise ein Physikbuch aus dem Blickwinkel des Fußballs für einen Hobbykicker.

KI kann noch kein vernünftig klingendes Interview führen

Der chinesisch-US-amerikanische Informatiker und KI-Forscher Andrew Ng zeigte sich in einem Interview am 8. Februar 2021 in der Frankfurter Allgemeinen Zeitung deutlich zurückhaltender. Auf die Frage, ob ihn nicht schon Künstliche Intelligenz statt eines Reporters interviewen könnte, antwortete er, davon, dass dabei ein vernünftig klingendes Gespräch herauskäme, seien wir noch weit entfernt. Auch eine offene Konversation über ein frei gewähltes Thema mit sinnvollen Beiträgen übersteige momentan noch die Fähigkeiten der Algorithmen. Bei dem für den Guardian-Artikel benutzten GPT-3-Textgenerator sieht er ebenfalls noch Verbesserungspotential.

Vor allem einfache Texte lassen sich automatisiert erstellen

Dass in Zukunft einfach strukturierter Internetcontent und wiederkehrende Routinemeldungen vermehrt durch Software erstellt werden, wird wenige Texter und Journalisten stören. Auch Medienanbieter werden die sich bietenden Rationalisierungen für Einsparungen gewiss nutzen.

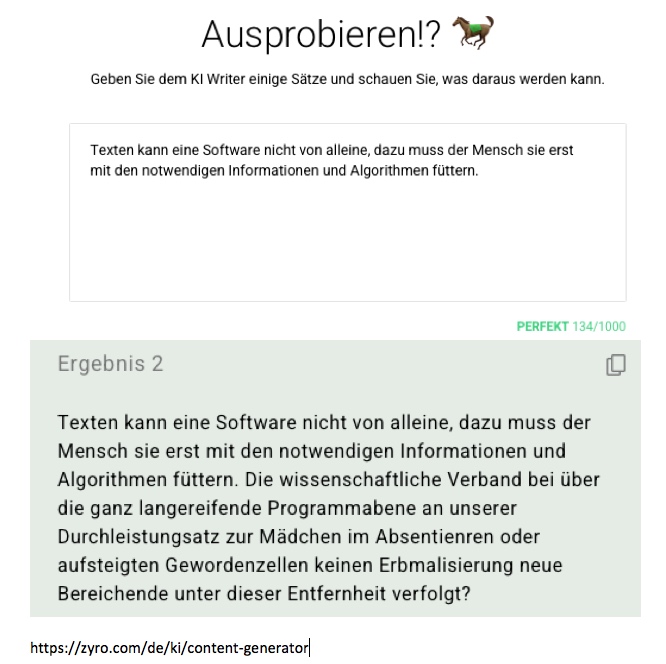

Und obwohl Google & Co. suchmaschinenoptimierte Internetinhalte favorisiert und entsprechende Hilfstools zahlreicher Anbieter den Content in diese Richtung hintrimmen, muss ein Text zuerst einmal von einem Mensch geschrieben werden. Mein Versuch, automatisierten Text mit einem „KI-Writer“ zu erstellen, war auf jeden Fall ein Desaster. Hierzu habe ich den kostenlosen Content-Generator genutzt, mit dem die litauische Firma Zyro Inc. auf ihrer Website wirbt. Dort habe ich den Satz „Texten kann eine Software nicht von alleine, dazu muss sie der Mensch erst mit den notwendigen Informationen und Algorithmen füttern.“ eingegeben. Der „KI-Generator“ hat den Text dann ergänzt.

Das Ergebnis ist ein wirres Gefasel:

Die menschliche Fähigkeit zur Kreativität ist weiterhin gefragt

Ein perfekt suchmaschinenoptimierter Internettext, den die Websitebesucher nach zehn Sekunden wegkicken, ist im doppelten Sinne gescheitert: Er wird nicht vom Menschen gelesen und von Google abgestraft, da die Verweildauer sehr kurz war. Ein Merkmal, bei dem die meisten Web-Analysten davon ausgehen, dass Google es als Rankingfaktor berücksichtigt.

Selbst wenn mit anderen Content-Generatoren bessere Texte entstehen – letztlich müssen sie nicht nur Programmen und Webcrawlern gefallen, sondern auch den Menschen, die sie lesen sollen. Denn für diese werden sie gemacht.

Daher bin ich sicher, dass die menschliche Fähigkeit zur Kreativität beim Schreiben noch lange eine wichtige Rolle spielen wird.

Weitere Informationen zum Thema Roboterjournalismus und Automated Content:

- ICON Group International Inc.: https://www.icongrouponline.com

- Philip M. Parker: https://www.insead.edu/faculty-research/faculty/philip-m-parker

- The Guardian, 8. September 2020, “Robot wrote this article”: https://www.theguardian.com/commentisfree/2020/sep/08/robot-wrote-this-article-gpt-3

- Robotertexte auf Fußball.de: http://www.fussball.de/newsdetail/faq-zu-neuen-robotertexten-auf-fussballde/-/article-id/203377#!/

- Deutsche Anbieter automatisierter Texte: https://www.retresco.de, https://de.ax-semantics.com, https://www.textomatic.ag

- Kostenloser Content-Generator von Zyro Inc. zum ausprobieren: https://zyro.com/de/ki/content-generator

- Stefan Weber: Roboterjournalismus, Chatbots & Co. Wie Algorithmen Inhalte produzieren und unser Denken beeinflussen, Heise Medien, Hannover 2018, 150 Seiten.

- Stefan Weber schreibt auch bei Telepolis auf https://www.heise.de/tp/

- Patrick Reichelt: Einführung in den Roboterjournalismus: Bedrohung oder Chance? Tectum Verlag, Baden-Baden 2017, 114 Seiten

Randnotiz TotoGEO

Mit den Einnahmen, den der Buchverlag ICON Group International Inc. mit „Automated Content“ erzielt, hat Philip M. Parker, zusammen mit der Bill & Melinda Gates Foundation 2015, das Projekt „TotoGEO“ ins Leben gerufen. „Toto“ ist aus dem Lateinischen für „uinversal“, GEO steht für Global Education and Outreach (dt. sinngemäß Globale Bildung und Kontakt). Ziel ist es, mit automatisch erstellten Lehrbüchern, Spielen, Content, Podcasts und Apps in über 300 afrikanischen und asiatischen Sprachen die Alphabetisierung voranzutreiben. https://www.totogeo.org

von: F. Stephan Auch